ZCU102兼容开发板:高性能边缘计算的优选方案

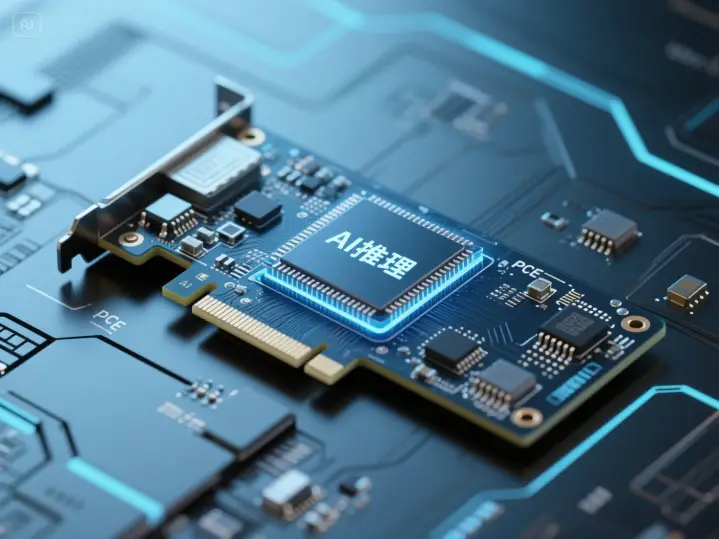

玄宇芯大模型推理卡:解锁大规模语言模型高效推理的新篇章

RAG知识库系统:赋能企业知识管理,加速业务决策

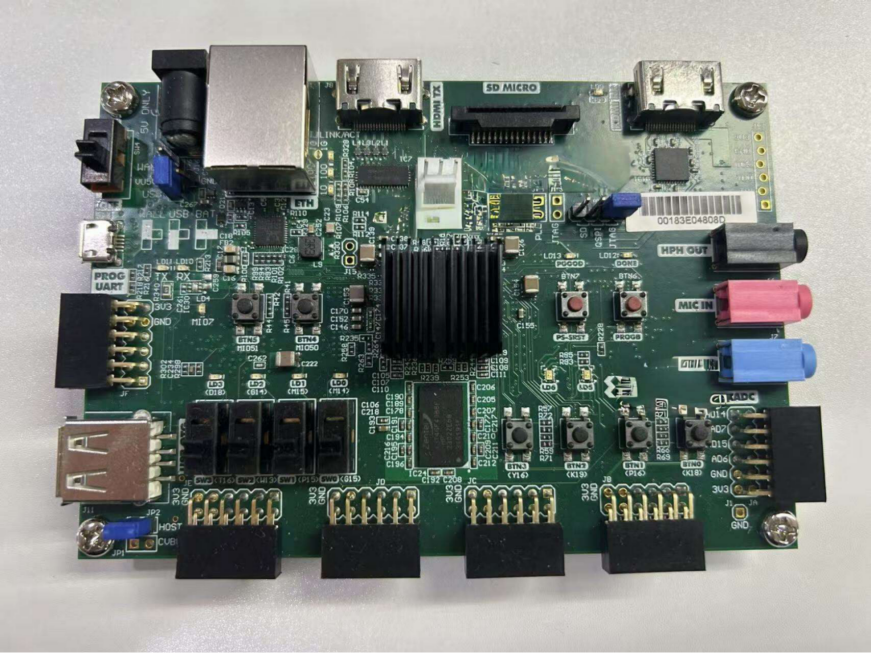

RISC-V + 自研DPU边缘算力开发板:解锁边缘计算的无限可能

玄宇芯大模型推理加速卡:专为千亿参数模型设计的国产算力引擎

YOLO算法在边缘计算中的技术演进与产业化趋势

AI知识库:驱动高效管理与智能决策的引擎

AI 知识库:重构用户交互模式的技术革命

AI 知识库市场 2024 年格局解析:规模、竞争与未来趋势深度洞察

企业级AI知识库有哪些实践应用 具体适合哪些行业的呢

AI知识库是什么怎么创建 有哪些行业的应用场景介绍一下案例

AI知识库的行业现在可以进入吗 市场竞争怎么样

在人工智能技术日新月异的今天,大规模语言模型(LLM)的应用越来越广泛,从智能客服到内容创作,从知识问答到个性化推荐,大模型正逐步渗透到我们生活的方方面面。然而,大模型的高效推理一直是个技术难题,高算力需求与高昂的能耗成本限制了其广泛应用。今天,我们来介绍一款专为解决这一问题而生的创新产品——玄宇芯大模型推理卡。

自研LPU,专为语言模型优化

玄宇芯大模型推理卡的核心在于其自研的LPU(Language Processing Unit)。与通用的GPU不同,LPU针对Transformer类模型的稀疏计算、低精度运算和注意力机制进行了深度优化。这种专有的设计使得LPU在处理大模型推理任务时,能够展现出更高的算力密度和能效比。

高性能,低功耗

在性能表现上,玄宇芯大模型推理卡同样令人瞩目。它支持高达320亿参数的语言模型,Token吞吐率达到每分钟2000个以上,能够满足大规模并发推理的需求。同时,得益于LPU的高效架构设计,该推理卡的标称功耗仅为约120W,显著低于同级GPU产品的250-300W功耗水平。这意味着,在提供相同算力的情况下,玄宇芯大模型推理卡能够大幅降低数据中心的能耗与散热压力,为运营商节省可观的运营成本。

灵活扩展,满足大规模部署

对于需要大规模部署的场景,玄宇芯大模型推理卡同样游刃有余。它支持多芯片互联,可以实现近线性的性能扩展,满足大规模语言模型推理的算力需求。这种灵活的扩展性使得玄宇芯大模型推理卡能够适用于各种规模的AI应用,从小型创业团队到大型科技企业,都能找到适合自己的解决方案。

无缝对接,部署简便

在兼容性方面,玄宇芯大模型推理卡也做得相当出色。它无缝对接主流AI框架与中间件,如TensorFlow、PyTorch等,使得开发者可以轻松地将其集成到现有的AI系统中。此外,玄宇芯还提供了丰富的开发文档和示例代码,进一步降低了开发门槛,使得即使是初学者也能快速上手。

应用场景广泛,推动行业变革

玄宇芯大模型推理卡凭借其高性能、低功耗和易集成的特点,在多个行业领域展现出了广泛的应用前景。在电商、金融等客服咨询量密集的行业,玄宇芯大模型推理卡可以支持高并发的在线智能客服系统,提供流畅无卡顿的对话体验,同时大幅降低运营成本。在直播平台,它可以作为实时互动助手,实现弹幕内容审核、主播话术建议等功能,提升直播间的互动性和用户体验。此外,玄宇芯大模型推理卡还可以应用于企业级智能知识库问答系统,提升企业内部文档的检索效率和准确度。

玄宇芯大模型推理卡的问世,标志着大规模语言模型高效推理进入了一个新的阶段。它以其自研的LPU架构、高性能低功耗的特点以及广泛的应用前景,为AI技术的普及和应用提供了有力的支持。在未来,随着AI技术的不断发展,玄宇芯大模型推理卡有望在更多领域发挥出其独特的价值,推动人工智能技术的持续创新和进步!

以上内容来源于:https://www.honganinfo.com/computing-power/inference-chip/